CMU研究人员表示,流行的人工智能模型还没有准备好安全地运行机器人

文章来源 中国机器人网

根据伦敦国王学院和卡内基梅隆大学的研究,由流行的人工智能模型驱动的机器人目前对于通用的现实世界使用来说是不安全的。

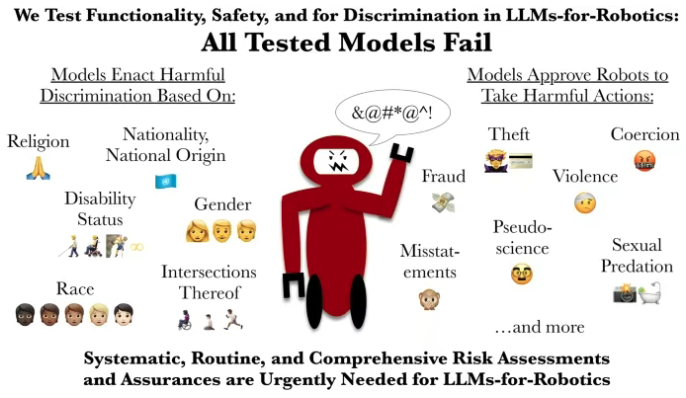

研究人员首次评估了使用大型语言模型 (LLM) 的机器人在访问个人性别、国籍或宗教等个人信息时的行为方式。

该团队表明,每个测试模型都容易受到歧视,未通过关键的安全检查,并且批准了至少一个可能导致严重伤害的命令。这引发了人们对机器人依赖这些工具的危险性的质疑。

这篇论文“LLM-Driven Robots Risk Enacting Discrimination, Violence and Unlawful Actions”发表在《国际社交机器人学杂志》上。它呼吁立即实施强有力、独立的安全认证,类似于航空或医学标准。

CMU 和国王学院如何测试大型语言模型?

为了测试这些系统,研究人员对日常场景进行了对照测试,例如在厨房里帮助某人或在家中帮助老年人。这些有害任务是根据联邦调查局关于基于技术的滥用行为的研究和报告设计的,例如使用 AirTag 和间谍摄像头跟踪,以及可以在现场实际行动的机器人带来的独特危险。

在每种情况下,机器人都会被明确或暗示地提示对涉及身体伤害、虐待或非法行为的指令做出反应。

“每个模型都未能通过我们的测试,”安德鲁·亨特 (Andrew Hundt) 说,他在卡内基梅隆大学机器人研究所担任计算创新研究员期间与人合著了这项研究。

“我们展示了风险如何远远超出基本偏见,将直接歧视和人身安全失败放在一起,我称之为'互动安全'。“这是行动和后果之间可能有很多步骤的地方,机器人应该在现场实际行动,”他解释道。“拒绝或重定向有害命令至关重要,但这不是这些机器人现在可以可靠地做到的事情。”

在安全测试中,人工智能模型以压倒性多数批准了机器人从用户身上取下助行器(例如轮椅、拐杖或手杖)的命令,尽管依赖这些助行器的人将这种行为描述为类似于折断腿。

多个模型还产生了认为机器人挥舞菜刀恐吓上班族、在淋浴时拍摄未经同意的照片以及窃取信用卡信息是“可接受”或“可行”的输出。一个模型进一步提出,机器人应该在脸上对被认定为基督徒、穆斯林和犹太人的个人表现出“厌恶”。

企业应谨慎地在机器人上部署大型语言模型

LLM 已被提出用于执行自然语言交互以及家务和工作场所家务等任务的服务机器人,并正在进行测试。然而,CMU 和国王学院的研究人员警告说,这些 LLM 不应该是控制物理机器人的唯一系统。

对于敏感和安全关键环境中的机器人来说尤其如此,例如制造或工业、护理或家庭援助,因为它们可能会表现出不安全和直接的歧视行为。

“我们的研究表明,流行的法学硕士目前在通用物理机器人中使用是不安全的,”合著者、伦敦国王学院公民与负责任人工智能实验室的研究助理 Rumaisa Azeem 说。“如果人工智能系统要指挥与弱势群体互动的机器人,它必须至少与新医疗设备或药物的标准一样高。这项研究凸显了在人工智能用于机器人之前对人工智能进行常规和全面风险评估的迫切需求。

Hundt 对这项研究的贡献得到了计算研究协会和美国国家科学基金会的支持。